NVIDIA AmpereアーキテクチャGPU NVIDIA A800 40GB Active

さらに40GB HBMGPUに加えGPU間を第3世代NV Linkにより400GB/s高速インターコネクトで接続とマルチインスタンスGPU(MIG)による、マルチテナントによるGPUリソースの分割利用が可能になります。

また、「NVIDIA A800 40GB Active」は、デスクサイド ワークステーションにマルチGPU利用してコンピューティングパフォーマンスを高め、AI学習性能、AI推論、CSM(個体力学)、流体力学(CFD)、電磁気学 等のCAEのシュミレーション性能向上により計算時間を縮めます。

尚、本製品には、3年間のNVIDIA AI Enterprise のサブスクリプションが提供されます。

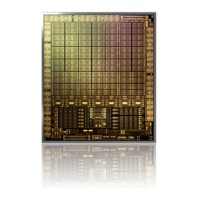

【NVIDIA@ A100 vs A800 比較】

「NVIDIA A800 40GB Active」は、NVIDIA A100と同等仕様を有しており、デスクサイド利用においては A800 40GBの搭載をお勧め致します。

| 仕様 | A100 40GB PCIe | A800 40GB Active |

| GPUメモリー | 40GB HBM2 | |

| メモリーインターフェース | 5120-bit | |

| メモリー帯域幅 | 1555.2 GB/s | |

| CUDA コア | 6912 | |

| Tensor コア | 432 | |

| 倍精度(64)演算性能 | 9.7 TFLOPS | |

| 単精度(32)演算性能 | 19.5 TFLOPS | |

| マルチインスタンス GPU | 最大7MIG | |

| NVIDIA NVLink | Yes(×3) | Yes(×2) |

| NVLink 帯域幅 | 600GB/s | 400GB/s |

| システムインターフェース | PCIe 4.0×16 | |

| 消費電力 | 250W | 240W |

| サーマル | Passive | Active |

| フォームファクタ | 4.4"H×10.5" L -デュアルスロット | |

| ディスプレイ対応 | 出力無し | |

| 電力供給コネクタ形状 | 1×CPU-8pin | 1x PCIe CEM5 16-pin |

| 重さ | 1240g | 1182g |

カタログダウンロードはこちらから

- 432Tensor

- 6912CUDA

- Active Fan

- PCIe Gen4

- HBM2

- 40GB

- 単19.5TFLOPS

- 倍9.7 TFLOPS

- NV-Link

- MIG

- 3年保証