4GPUサーバー GSV-IEMSM-4U4G

カスタマイズメニューに無い構成はお気軽に弊社までお問い合わせ下さい。お客様のご要望に合わせて抜群のコストパフォーマンスと安定した利用環境をご提供します。

NVIDIA RTX PRO 6000 Blackwell シリーズ製品比較レポート

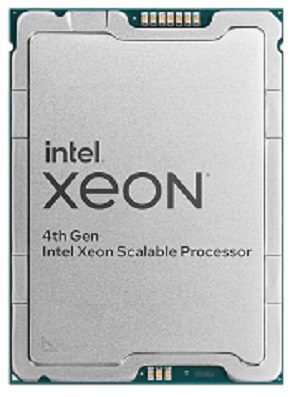

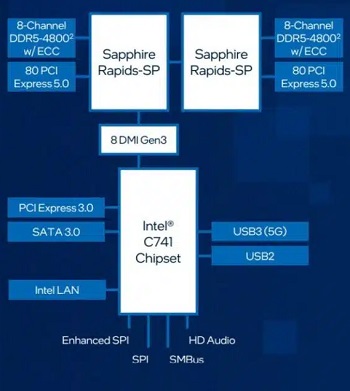

- Intel Xeon

- 2CPU

- 4GPU

- 10GbE

- IPMI

- SATA

- M.2

- slim SAS

- NVMe

- 16 DIMM slots

- DDR5

- ECC Registered

- 3年保証