こちらの製品は若干数在庫がございます。

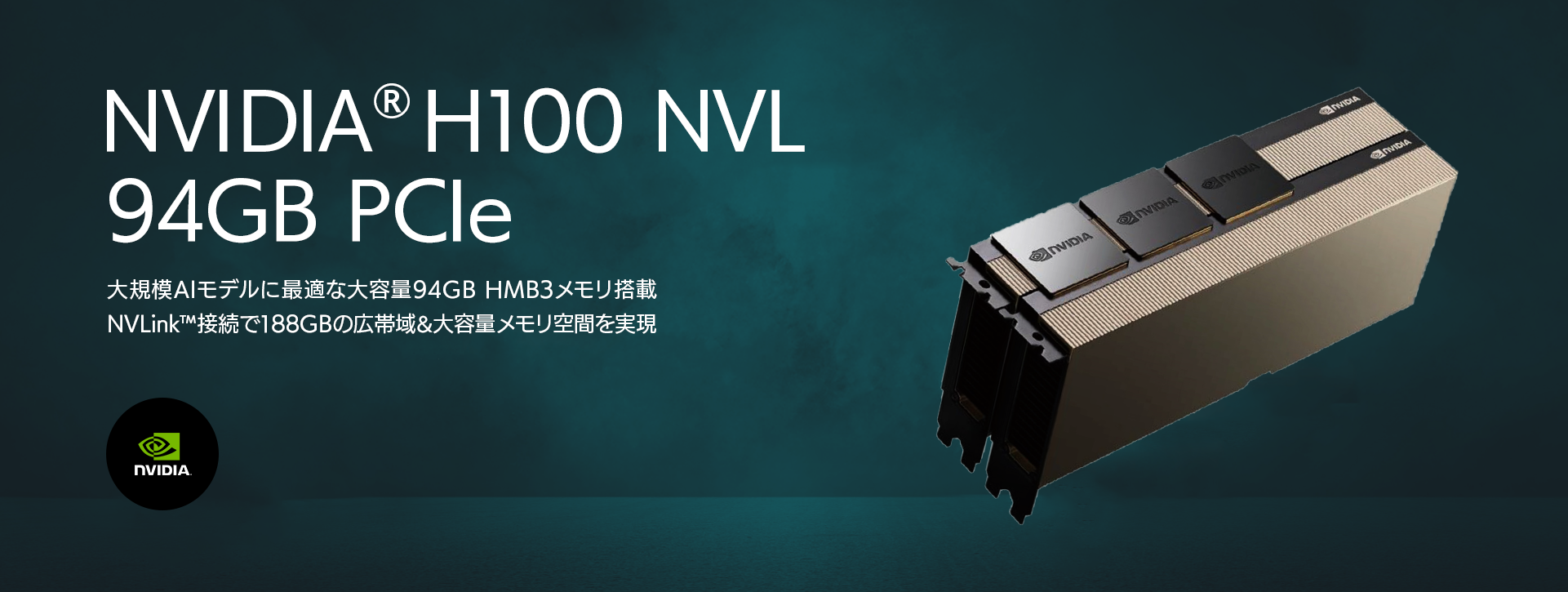

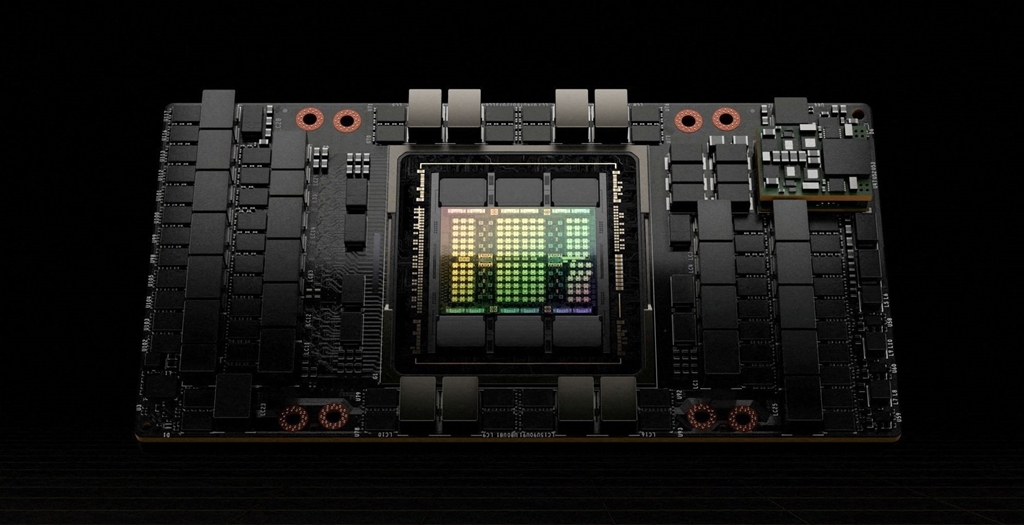

NVIDIA® H100 NVL は、最新のGPUアーキテクチャ「Hopper」を採用し、大容量94GB Bandwidth7.8TB/sの高性能HBM3メモリ、第4世代のTensorコア、前世代となるNVIDIA A100 GPUの約1.5倍にあたる800億個のトランジスタが搭載されています。

さらに、2枚の「H100 NVL」をNVLink(TM)で接続することにより188GBの広大なメモリ空間を実現し、各GPU間は600GB/sの広帯域で疎通可能で生成AIのような大規模AIモデルの学習に最適なハイエンドスペックとなっています。米OpenAI社がChat GPT-3(GPT-175Bモデル)の開発に利用したNVIDIA A100と比較して最大12倍の高速化を実現します。また、H100 NVLはPCI Gen5 で搭載が可能ですので、既存のGPUサーバーインフラで置換や増設も可能です。

※本製品は消費電力が非常に高くNVIDIAが認定したシステムにのみ搭載が可能です。動作認証済のシステムや搭載方法については弊社までご相談下さい。

※NVLinkでのGPU接続は、NVIDIA H100 NVL を2枚接続する際に有効です。異なるGPUカードや、同じH100シリーズでも40GBや80GBのカードとの接続は動作保障外となりますのでご注意ください。

- PCIe Gen5

- HBM3

- 94GB

- NV-Link

- MIG

- 3年保証