GPUメモリサイズにおける学習パフォーマンスの違い

Geforce最上位機種として3090Tiが発表されました。従来品と同じGA102チップを使いながらもメモリクロックを向上し40TFLPSの処理性能を実現したとのことです。一方でメモリ容量は24GBと従来の3090と同程度となっています。

また、昨年12月を以てハイエンドコンピューティングカードNVIDIA A100やA100搭載のアプライアンスサーバーDGX A100について、メモリ容量が40GBのモデルの販売が終了し80GBモデルに集約されました。

そこで当社では現行のGPUカードでメモリ容量が学習効果にどの程度影響を与えるか検証してみました。

※今回発表になった3090Tiもデリバリが開始され次第、動作検証とベンチマークを追加して参ります。

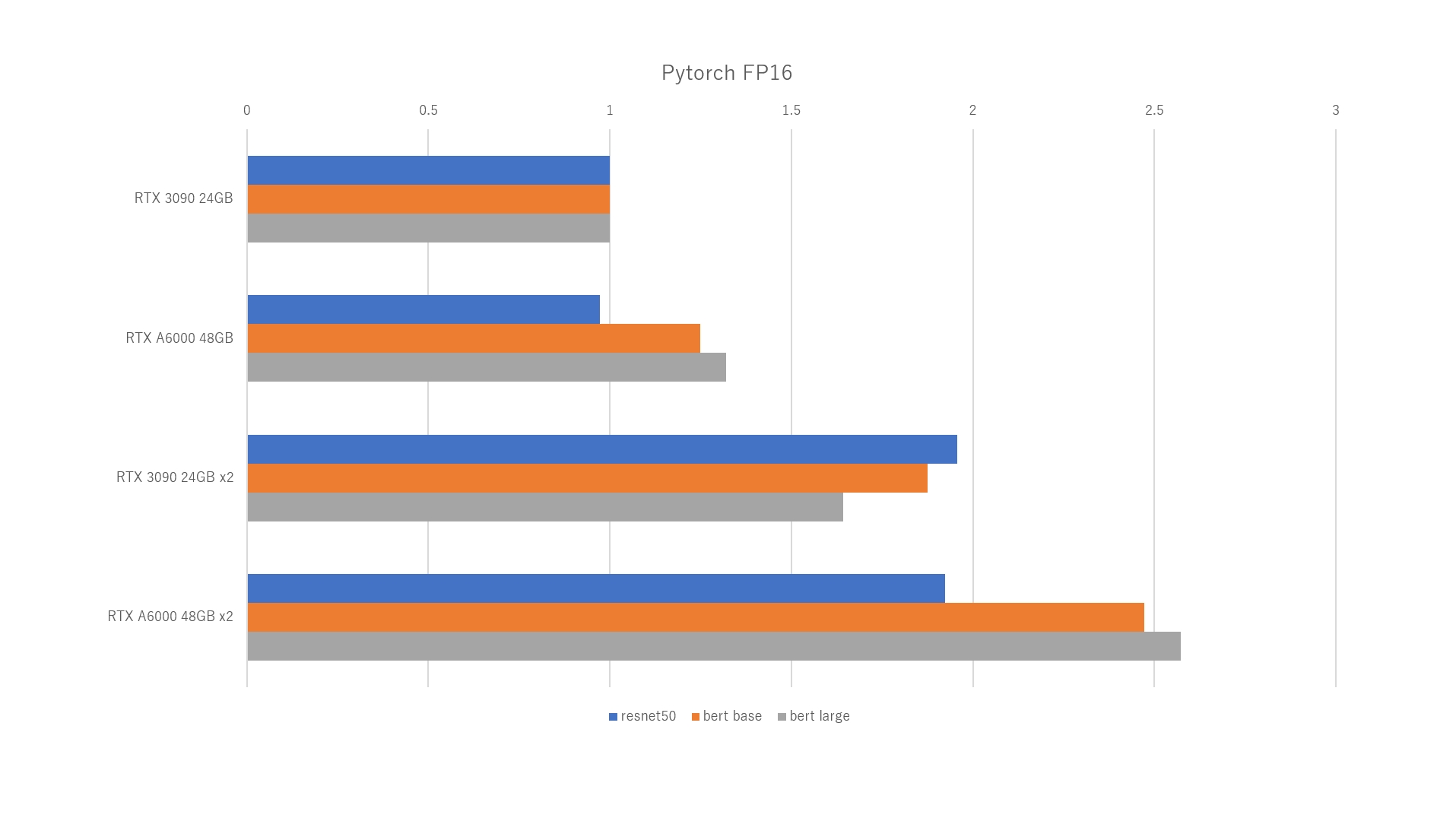

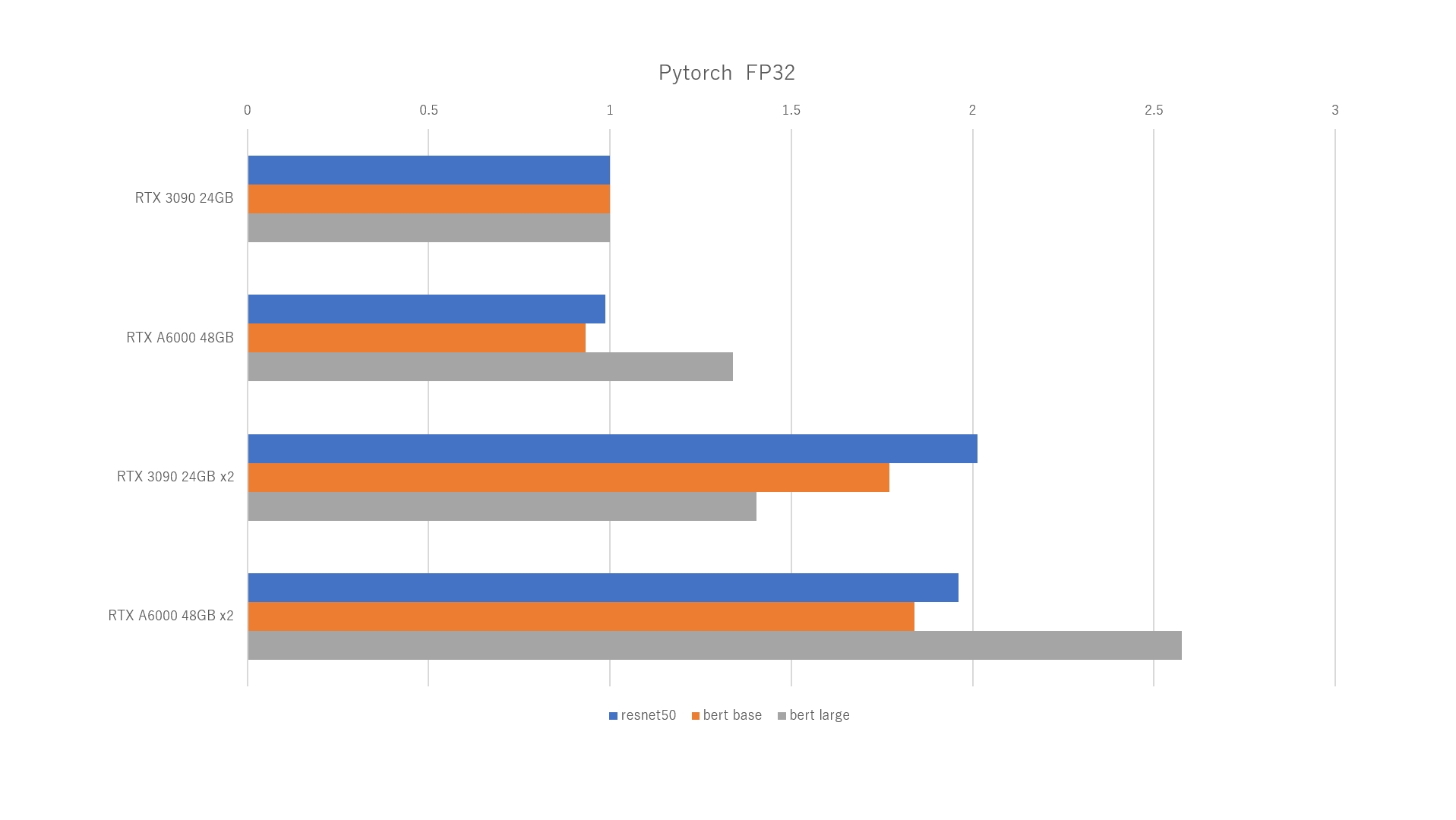

検証1 Geforce3090 24GB vs NVIDIA A6000 48GB

<検証環境>

DeeplearningBOXII

https://www.gdep.co.jp/products/list/v/5c4fe41b039d3

Geforce3090 x1基の学習パフォーマンス(Image/sec)を1とした場合の比較

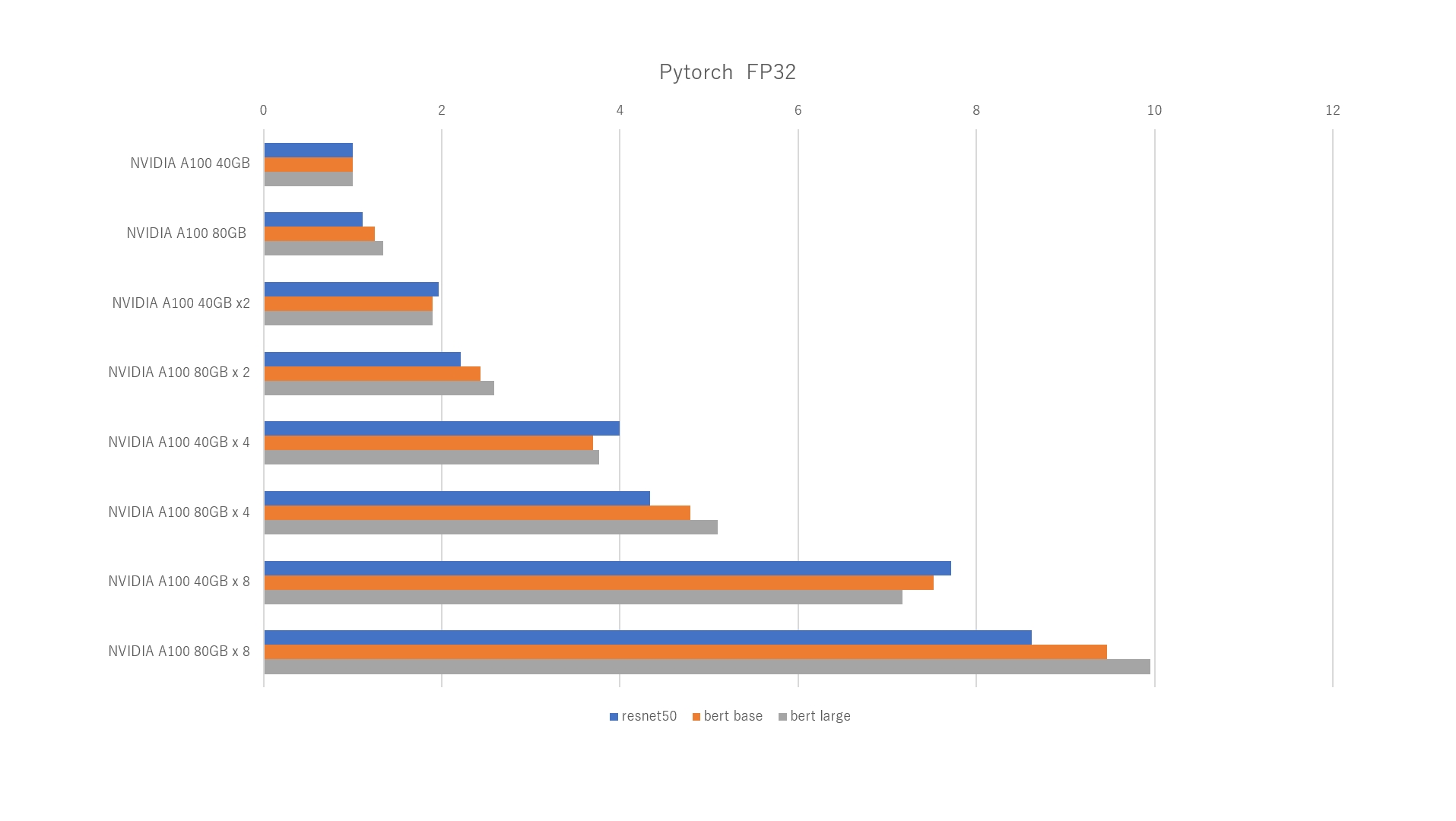

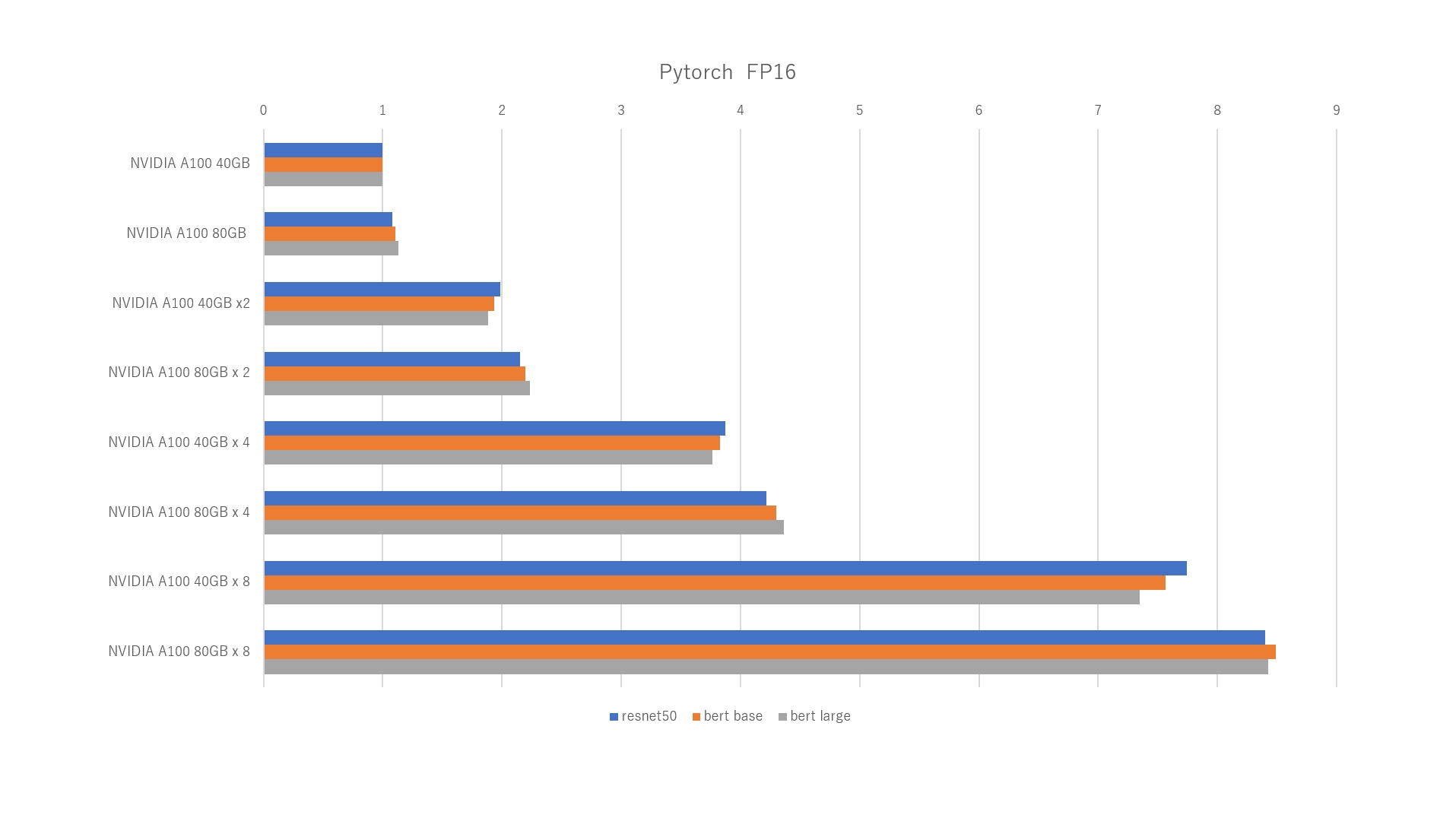

検証2 DGX A100 320GB vs DGX A100 640GB

<検証環境>

NVIDIA DGX A100

https://www.gdep.co.jp/products/list/cpu/92/136/

NVIDA A100 40GB x1基の学習パフォーマンス(Image/sec)を1とした場合の比較

結論

BertなどNLPの学習モデルはハイパーパラメーターや大きなバッチサイズに対応したGPUメモリサイズがパフォーマンスに大きく影響しています。またBertではバッチサイズを大きくしたほうが安定した学習が可能とも言われています。今回取得はしていませんがTransformer や GPT-3など多層ニューラルネットの自然言語処理系モデルでも同様と考えられます。

物体検出などでも解像度の高い学習データを扱う場合にはメモリ不足に注意が必要です。

GPUメモリは後から増設ができませんので、ひとつの方法としては複数のGPUを利用してメモリサイズを稼ぐ方法が挙げれます。

最近のディープラーニングのモデルは巨大化が進み、大規模メモリが必須となっていますが、自然言語処理系の巨大モデルに限らず、メモリの大きさは機械学習・ディープラーニングの学習において強みであり、おそらくは48GBや80GBメモリーモデルが今後メインストレームになっていくものと思われます。昔からスパコンを買うことはメモリを買うことだ、と言われて来ましたが、データを演算機の近くに置いてなるべく動かさないことこそ最適化の要諦であり、予算の許す限り大きなメモリのシステムをお勧め致します。

ワークステーションタイプ 大容量メモリGPUカード ※アカデミック向け&インセプションパートナー向けキャンペーン実施中

NVIDIA A6000 48GB

サーバータイプ 大容量メモリGPUカード

NVIDIA A100 80GB